In de nabije toekomst zal kunstmatige intelligentie (AI) je bedrijf naar een hoger niveau tillen. Het zal de productiviteit, het gebruik van resources, de onderhoudbaarheid, de efficiëntie van het personeelsbestand en nog veel meer verhogen. Maar voordat dat kan gebeuren, moet je gegevens verzamelen en genoeg voorbeelden geven om je AI-algoritmes te trainen. Of je bedrijf nu actief is in de financiële sector of in de medische sector, of je je nu richt op warehousing of afvalverwerking, elk bedrijf heeft één ding gemeen: er stromen al gegevens door de organisatie.

Deze blogpost wil je bewust maken van het belang van gegevensverzameling als opstap naar Kunstmatige Intelligentie. Alleen als je gegevens zichtbaar, adequaat en aangevuld zijn met externe gegevens en representatief zijn voor je demografie, kun je profiteren van positieve kansen die zich voordoen in de wereld van vandaag en kun je betere zakelijke beslissingen nemen.

Wat is kunstmatige intelligentie?

Kunstmatige intelligentie (AI) in zijn eenvoudigste vorm is de imitatie van menselijke intelligentie door een machine. Met andere woorden, het stelt programma's in staat om mensachtige beslissingen te nemen en mensachtige redeneringen te volgen. Een populair subdomein van Kunstmatige Intelligentie is Machine Learning. In plaats van expliciet een reeks regels te programmeren, leiden Machine Learning-toepassingen patronen af uit voorbeelden en 'leren' ze hoe dingen werken.

Verberg uw gegevens

Toegankelijke gegevens kunnen goed gebruikt worden. Er is vast wel iemand die weet hoeveel mensen er voor je bedrijf werken, hoeveel voorraad je bijhoudt, hoeveel voorraad je de afgelopen maanden hebt verplaatst en hoe je fabriek scoort op efficiëntie en productiviteit. Maar wat gebeurt er met deze gegevens als ze eenmaal zijn verzameld? Een mooie presentatie voor het bestuur? Zijn deze cijfers ergens in de cloud opgeslagen? Misschien zijn ze beschikbaar in een gecentraliseerde database? Of, erger nog, misschien staan ze in een Excel-bestand op een privéschijf stof te verzamelen?

In veel bedrijven heeft slechts een beperkt aantal mensen toegang tot bepaalde bedrijfsmiddelen. Omdat dit betekent dat gegevens geïsoleerd zijn van de rest van de organisatie, noemen we ze informatiesilo's. Dit impliceert niet alleen wantrouwen in de organisatie, het beperkt ook het team of de applicatie die de gegevens verwerkt. Voor dezelfde gegevens kunnen er verschillende interpretaties zijn tussen teams, of een correlatie tussen kenmerken kan verborgen blijven omdat de gegevens over verschillende silo's zijn verspreid.

Er is een groot voordeel wanneer gegevens algemeen beschikbaar zijn op een gestandaardiseerde manier. Je kunt niet alleen vertrouwen op de betrouwbaarheid van de bron, maar je kunt ook een minimum aan kwaliteit en volledigheid garanderen. Als je een bedrijfscultuur opbouwt waarin gegevens centraal staan en vandaag begint met het verzamelen van die gegevens op een uniforme manier, zullen ze morgen je kunstmatige intelligentie voeden.

Bewaar meer dan alleen JOUW gegevens

Hoewel het voorspellen van de toekomst nooit zeker is, kun je verrassingen voorkomen door externe factoren mee te nemen. Als je bijvoorbeeld elektrische auto's verkoopt, kan een stijgende olieprijs een positieve invloed hebben op je verkoop. Een verandering in het overheidsbeleid kan daarentegen een negatieve invloed hebben. Een hittegolf kan ervoor zorgen dat je werknemers meer pauzes moeten nemen om uitputting te voorkomen, wat een invloed heeft op de productiviteit. Zelfs het annoteren van gegevens met bedrijfsinitiatieven kan gunstig zijn: marketingcampagnes resulteren (hopelijk) in een grotere zichtbaarheid van je organisatie en oplossingen, wat leidt tot meer verkoop. Daarom moeten de cijfers van je organisatie worden opgeslagen samen met externe feiten en cijfers die invloed hebben op de processen die waardevol zijn voor je bedrijf.

Een algoritme voor machinaal leren kan gemakkelijk rekening houden met deze extra parameters om een verband te leggen tussen meerdere gegevenssets. Het kan onderscheid maken tussen seizoensgebonden effecten, het effect van klimatologische omstandigheden en een algemene trend van stijgende verkoopcijfers.

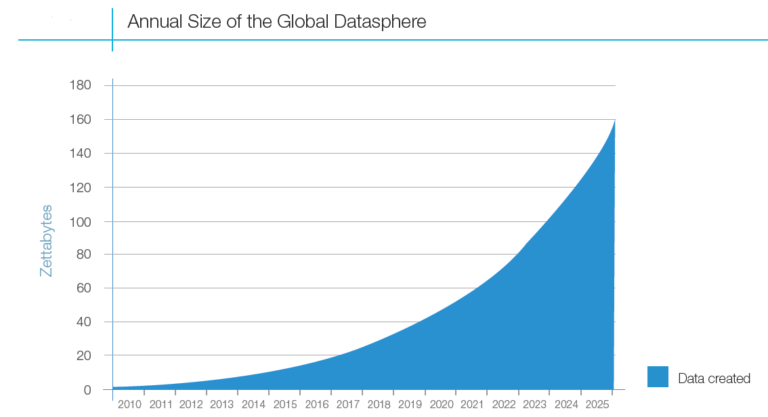

Het centraliseren van de besluitvorming rond bedrijfsgegevens is belangrijk, maar dat geldt ook voor externe gegevens: de wereld om ons heen verandert voortdurend. Wees voorbereid om VEEL gegevens te verzamelen.

Wees op je hoede voor bevooroordeelde gegevens

Er zijn veel voorbeelden van gevallen waarin datamining ten onrechte heeft geconcludeerd wat het belang is van een bepaalde invoerfunctie. Een volledige weergave van je inventaris of klantenbestand is van vitaal belang voor de impact van gegevensanalyse. Daarnaast kan het normaliseren van je invoer voorkomen dat je model zich ooit bewust wordt van ongewenste kenmerken. Een neuraal netwerk dat is ontworpen om huidkanker te detecteren, was in staat om bij het analyseren van foto's een correlatiete identificeren tussen de aanwezigheid van een liniaal naast een tumor. In een poging om wolven en husky's te classificeren, selecteerden wetenschappers opzettelijk afbeeldingen met een specifieke achtergrond om hun algoritme te trainen. Dit bewijst dat bevooroordeelde gegevens leiden tot een onnauwkeurig model voor machinaal leren. Dit is een probleem waar zelfs ervaren datawetenschappers mee te maken krijgen. Geen wonder dat experts zeggen dat ze meer tijd besteden aan het voorbereiden van de gegevens dan aan het ontwerpen en trainen van modellen...

"Het heeft meer zin om je zorgen te maken over de gegevens en minder kieskeurig te zijn over welk algoritme je moet toepassen."

- Kunstmatige intelligentie: Een moderne benadering (S. Russell en P. Norvig)

Ook al zijn verzamelde gegevens erg waardevol voor je bedrijf, je hebt ze waarschijnlijk niet verzameld met het gebruik voor AI-toepassingen in gedachten. Daarom bevatten ze waarschijnlijk verstorende kenmerken die het leerproces zullen beïnvloeden. Het is van vitaal belang om vanaf nu na te denken over je dataverzameling en deze te beoordelen als je ze wilt voorbereiden op gebruik in AI-toepassingen.

Takeaway

Steeds meer bedrijven veranderen hun processen in datagestuurde processen om een concurrentievoordeel te behalen. Om te begrijpen hoe bepaalde aspecten je productiviteit beïnvloeden, is het belangrijk om gegevens van hoge kwaliteit te verzamelen. Als je bronnen betrouwbaar zijn en je een geschikte toepassing hebt om inzichtelijke patronen te presenteren, kun je deze gebruiken om zakelijke beslissingen te ondersteunen.

Vandaag de dag is het verzamelen van gegevens niet het moeilijkste deel. Er zijn genoeg tools die je daarbij helpen. De echte uitdaging ligt in het structureren en vastleggen van dejuiste gegevens . Het is niet eenvoudig om een oplossing te vinden die geschikt is voor uw specifieke geval, maar u kunt beginnen met het opzetten van een database of datawarehouse, nadenken over hoe u uw gegevens gaat structureren en deze vervolgens toepassen. Als u hulp nodig hebt of als u vragen hebt, klik dan hier om contact met ons op te nemen en stuur ons een bericht!

Onderneem vandaag nog actie, want weten hoe je dit kunt realiseren kost tijd en oefening. Bereid je bedrijf voor op een datagestuurde cultuur en begin met het opbouwen van kennis over machine learning om het potentiële voordeel dat je uit je gegevens haalt te benutten.

What others have also read

Bij ACA zijn de Ship-IT Days no-nonsense innovatiedagen.

Lees verder

Of we nu onze telefoons ontgrendelen met gezichtsherkenning, stemcommando's roepen naar onze slimme apparaten vanaf de andere kant van de kamer of een lijst krijgen voorgeschoteld met films die we misschien leuk vinden... machine learning heeft in veel gevallen ons leven ten goede veranderd. Maar zoals met veel geweldige technologieën, heeft het ook een schaduwzijde. Een belangrijke is de massale, vaak ongereguleerde, verzameling en verwerking van persoonlijke gegevens. Soms lijkt het wel alsof er voor elk positief verhaal een negatief verhaal is over onze privacy die in gevaar is . Het is duidelijk dat we gedwongen zijn om privacy de aandacht te geven die het verdient. Vandaag wil ik het hebben over hoe we toepassingen voor machine learning kunnen gebruiken zonder dat we ons zorgen hoeven te maken over privacy en ons zorgen hoeven te maken dat privégegevens openbaar worden . Machine learning met randapparaten Door de intelligentie op randapparaten op locatie te plaatsen, kunnen we ervoor zorgen dat bepaalde informatie de sensor die deze vastlegt niet verlaat. Een randapparaat is een stuk hardware dat wordt gebruikt om gegevens dicht bij de bron te verwerken. In plaats van video's of geluid naar een gecentraliseerde processor te sturen, worden ze op de machine zelf verwerkt. Met andere woorden, je vermijdt dat al deze gegevens worden doorgestuurd naar een externe applicatie of een cloud-gebaseerde service. Edge-apparaten worden vaak gebruikt om latentie te verminderen. In plaats van te wachten tot de gegevens over een netwerk reizen, krijg je een onmiddellijk resultaat. Een andere reden om een edge device te gebruiken is om de kosten van bandbreedte te verlagen. Apparaten die gebruik maken van een mobiel netwerk werken mogelijk niet goed in landelijke gebieden. Zelfrijdende auto's maken bijvoorbeeld optimaal gebruik van beide redenen. Elke video-opname naar een centrale server sturen zou te tijdrovend zijn en de totale latentie zou de snelle reacties die we van een autonoom voertuig verwachten in de weg staan. Hoewel dit belangrijke aspecten zijn om te overwegen, ligt de focus van deze blogpost op privacy. Met de General Data Protection Regulation (GDPR) die in 2018 door het Europees Parlement van kracht werd, zijn mensen zich meer bewust geworden van hoe hun persoonlijke informatie wordt gebruikt . Bedrijven moeten toestemming vragen om deze informatie op te slaan en te verwerken. Sterker nog, overtredingen van deze verordening, bijvoorbeeld door geen adequate beveiligingsmaatregelen te nemen om persoonlijke gegevens te beschermen, kunnen leiden tot hoge boetes. Dit is waar edge devices in uitblinken. Ze kunnen een afbeelding of geluidsfragment onmiddellijk verwerken zonder dat er externe opslag of verwerking nodig is. Omdat ze de ruwe gegevens niet opslaan, wordt deze informatie vluchtig. Een randapparaat kan bijvoorbeeld camerabeelden gebruiken om het aantal mensen in een kamer te tellen. Als het camerabeeld op het apparaat zelf wordt verwerkt en alleen de grootte van de menigte wordt doorgestuurd, blijft ieders privacy gewaarborgd. Prototyping met Edge TPU Coral, een submerk van Google, is een platform dat software en hardware tools biedt om machine learning te gebruiken. Een van de hardwarecomponenten die ze aanbieden is het Coral Dev Board . Het is aangekondigd als " Google's antwoord op de Raspberry Pi ". Het Coral Dev Board draait een Linux-distributie gebaseerd op Debian en heeft alles aan boord om prototypes van machine learning-producten te maken. Centraal op het bord staat een Tensor Processing Unit (TPU) die is gemaakt om Tensorflow (Lite) bewerkingen uit te voeren op een energiezuinige manier. Je kunt meer lezen over Tensorflow en hoe het helpt om snel machinaal leren mogelijk te maken in een van onze eerdere blogposts . Als je goed naar een proces van machinaal leren kijkt, kun je twee fasen onderscheiden. De eerste fase is het trainen van een model op basis van voorbeelden, zodat het bepaalde patronen kan leren. De tweede fase is het toepassen van de mogelijkheden van het model op nieuwe gegevens. Bij het dev board hierboven is het de bedoeling dat je je model traint op cloudinfrastructuur. Dat is logisch, want voor deze stap is meestal veel rekenkracht nodig. Zodra alle elementen van je model zijn geleerd, kunnen ze naar het apparaat worden gedownload met behulp van een speciale compiler. Het resultaat is een kleine machine die een krachtig algoritme voor kunstmatige intelligentie kan uitvoeren terwijl hij niet is aangesloten op de cloud . Gegevens lokaal houden met Federated Learning Het bovenstaande proces doet je misschien afvragen welke gegevens worden gebruikt om het model voor machinaal leren te trainen. Er zijn veel openbaar beschikbare datasets die je kunt gebruiken voor deze stap. Over het algemeen worden deze datasets opgeslagen op een centrale server. Om dit te vermijden, kun je een techniek gebruiken die Federated Learning heet. In plaats van de centrale server het volledige model te laten trainen, doen verschillende nodes of edge devices dit individueel. Elk knooppunt stuurt updates over de parameters die ze hebben geleerd, ofwel naar een centrale server (Single Party) of naar elkaar in een peer-to-peer opstelling (Multi Party). Al deze wijzigingen worden vervolgens gecombineerd tot één globaal model. Het grootste voordeel van deze opzet is dat de opgenomen (gevoelige) gegevens nooit de lokale node verlaten . Dit is bijvoorbeeld gebruikt in Apple's QuickType toetsenbord voor het voorspellen van emoji's , op basis van het gebruik van een groot aantal gebruikers. Eerder dit jaar bracht Google TensorFlow Federated uit om applicaties te maken die leren van gedecentraliseerde data. Takeaway Bij ACA hechten we veel waarde aan privacy, net als onze klanten. Het privé houden van uw persoonlijke gegevens en gevoelige informatie is (y)onze prioriteit. Met technieken zoals federated learning kunnen we u helpen uw AI-potentieel te ontketenen zonder dat dit ten koste gaat van de gegevensbeveiliging. Benieuwd hoe dat precies in jouw organisatie zou werken? Stuur ons een e-mail via ons contactformulier en we nemen snel contact met je op.

Lees verder

De wereld van chatbots en Large Language Models (LLM's) heeft onlangs een spectaculaire evolutie doorgemaakt. Met ChatGPT, ontwikkeld door OpenAI, als een van de meest opmerkelijke voorbeelden, is de technologie erin geslaagd om meer dan 1.000.000 gebruikers te bereiken in slechts vijf dagen. Deze stijging onderstreept de groeiende interesse in conversational AI en de ongekende mogelijkheden die LLM's bieden. LLM's en ChatGPT: Een korte introductie Grote taalmodellen (LLM's) en chatbots zijn concepten die tegenwoordig onmisbaar zijn geworden in de wereld van kunstmatige intelligentie. Ze vertegenwoordigen de toekomst van mens-computerinteractie, waarbij LLM's krachtige AI-modellen zijn die natuurlijke taal begrijpen en genereren, terwijl chatbots programma's zijn die menselijke gesprekken kunnen simuleren en taken kunnen uitvoeren op basis van tekstuele invoer. ChatGPT, een van de opmerkelijke chatbots, heeft in korte tijd enorm aan populariteit gewonnen. LangChain: de brug naar LLM-gebaseerde toepassingen LangChain is een van de frameworks waarmee de kracht van LLM's kan worden benut voor het ontwikkelen en ondersteunen van toepassingen. Deze open-source bibliotheek, geïnitieerd door Harrison Chase, biedt een generieke manier om verschillende LLM's aan te spreken en uit te breiden met nieuwe gegevens en functionaliteiten. LangChain is momenteel beschikbaar in Python en TypeScript/JavaScript en is ontworpen om eenvoudig verbindingen te maken tussen verschillende LLM's en gegevensomgevingen. LangChain Kernconcepten Om LangChain volledig te begrijpen, moeten we enkele kernconcepten verkennen: Ketens: LangChain is gebouwd op het concept van een keten. Een keten is eenvoudigweg een generieke opeenvolging van modulaire componenten. Deze ketens kunnen worden samengesteld voor specifieke use cases door de juiste componenten te selecteren. LLMChain: Het meest voorkomende type keten binnen LangChain is de LLMChain. Deze bestaat uit een PromptTemplate, een Model (dat een LLM of een chatmodel kan zijn) en een optionele OutputParser. Een PromptTemplate is een sjabloon dat wordt gebruikt om een prompt voor de LLM te genereren. Hier is een voorbeeld: Met deze template kan de gebruiker een onderwerp invullen, waarna de ingevulde prompt als input naar het model wordt gestuurd. LangChain biedt ook kant-en-klare PromptTemplates, zoals Zero Shot, One Shot en Few Shot prompts. Model en OutputParser: Een model is de implementatie van een LLM-model zelf. LangChain heeft verschillende implementaties voor LLM modellen, waaronder OpenAI, GPT4All en HuggingFace. Het is ook mogelijk om een OutputParser toe te voegen om de uitvoer van het LLM-model te verwerken. Er is bijvoorbeeld een ListOutputParser beschikbaar om de uitvoer van het LLM-model om te zetten in een lijst in de huidige programmeertaal. Gegevensconnectiviteit in LangChain Om de LLM Chain toegang te geven tot specifieke gegevens, zoals interne gegevens of klantinformatie, gebruikt LangChain verschillende concepten: Documentladers Met documentloaders kan LangChain gegevens ophalen uit verschillende bronnen, zoals CSV-bestanden en URL's. Tekst Splitter Deze tool splitst documenten op in kleinere stukken zodat ze makkelijker verwerkt kunnen worden door LLM modellen, rekening houdend met beperkingen zoals tokenlimieten. Inbeddingen LangChain biedt verschillende integraties om tekstuele gegevens om te zetten in numerieke gegevens, zodat ze gemakkelijker te vergelijken en te verwerken zijn. Het populaire OpenAI Embeddings is hier een voorbeeld van. VectorStores Hier worden de ingesloten tekstuele gegevens opgeslagen. Dit kunnen bijvoorbeeld gegevensvectoropslagplaatsen zijn, waarbij de vectoren de ingesloten tekstuele gegevens vertegenwoordigen. FAISS (van Meta) en ChromaDB zijn enkele populaire voorbeelden. Retrievers Retrievers maken de verbinding tussen het LLM-model en de gegevens in VectorStores. Ze halen relevante gegevens op en breiden de prompt uit met de benodigde context, waardoor contextbewuste vragen en opdrachten mogelijk worden. Een voorbeeld van zo'n contextbewuste prompt ziet er als volgt uit: Demo toepassing Om de kracht van LangChain te illustreren, kunnen we een demotoepassing maken die de volgende stappen volgt: Gegevens ophalen op basis van een URL. De gegevens opsplitsen in hanteerbare blokken. De gegevens opslaan in een vector database. Een LLM toegang verlenen tot de vector database. Een Streamlit-toepassing maken die gebruikers toegang geeft tot de LLM. Hieronder laten we zien hoe je deze stappen in code uitvoert: 1. Gegevens ophalen Gelukkig vereist het ophalen van gegevens van een website met LangChain geen handmatig werk. Hieronder lees je hoe we dat doen: 2. Gegevens splitsen Het dataveld hierboven bevat nu een verzameling pagina's van de website. Deze pagina's bevatten veel informatie, soms te veel voor de LLM om mee te werken, omdat veel LLM's met een beperkt aantal tokens werken. Daarom moeten we de documenten opsplitsen: 3. Gegevens opslaan Nu de gegevens zijn opgesplitst in kleinere contextuele fragmenten, slaan we ze op in een vectordatabase om de LLM efficiënt toegang te geven tot deze gegevens. In dit voorbeeld gebruiken we Chroma: 4. Toegang verlenen Nu de gegevens zijn opgeslagen, kunnen we een "Chain" bouwen in LangChain. Een keten is simpelweg een reeks LLM-uitvoeringen om het gewenste resultaat te bereiken. Voor dit voorbeeld gebruiken we de bestaande RetrievalQA-keten die LangChain biedt. Deze keten haalt relevante contextfragmenten op uit de nieuw gebouwde database, verwerkt deze samen met de vraag in een LLM en levert het gewenste antwoord: 5. Streamlit toepassing maken Nu we de LLM toegang hebben gegeven tot de gegevens, moeten we de gebruiker een manier bieden om de LLM te raadplegen. Om dit efficiënt te doen, gebruiken we Streamlit: Agenten en hulpmiddelen Naast de standaardketens biedt LangChain ook de mogelijkheid om Agents te maken voor geavanceerdere toepassingen. Agents hebben toegang tot verschillende tools die specifieke functionaliteiten uitvoeren. Deze tools kunnen variëren van een "Google Search" tool tot Wolfram Alpha, een tool voor het oplossen van complexe wiskundige problemen. Hierdoor kunnen Agents geavanceerdere redeneertoepassingen bieden, waarbij ze beslissen welk hulpmiddel ze moeten gebruiken om een vraag te beantwoorden. Alternatieven voor LangChain Hoewel LangChain een krachtig raamwerk is voor het bouwen van LLM-gestuurde toepassingen, zijn er andere alternatieven beschikbaar. Een populair hulpmiddel is bijvoorbeeld LlamaIndex (voorheen GPT Index), dat zich richt op het verbinden van LLM's met externe gegevens. LangChain daarentegen biedt een completer framework voor het bouwen van applicaties met LLM's, inclusief tools en plugins. Conclusie LangChain is een spannend raamwerk dat de deuren opent naar een nieuwe wereld van conversationele AI en applicatieontwikkeling met grote taalmodellen. Met de mogelijkheid om LLM's te koppelen aan verschillende gegevensbronnen en de flexibiliteit om complexe toepassingen te bouwen, belooft LangChain een essentieel hulpmiddel te worden voor ontwikkelaars en bedrijven die willen profiteren van de kracht van LLM's. De toekomst van conversational AI ziet er rooskleurig uit en LangChain speelt een cruciale rol in deze evolutie.

Lees verderWant to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!