-Apr-18-2025-11-03-17-1486-AM.png?auto=compress,webp&upscale=true&width=610&height=488&name=Featured%20image%20(1)-Apr-18-2025-11-03-17-1486-AM.png)

Stel je voor dat je je cloudstrategie zou kunnen omvormen tot een fijn afgestelde machine die de kosten verlaagt en maximale bedrijfswaarde oplevert. Dat is precies wat we voor een van onze klanten hebben gedaan door FinOps met Azure te implementeren. Door middel van gerichte optimalisaties en een sterke focus op organisatorische afstemming hebben we onze klant geholpen duizenden euro's te besparen op zijn Azure-factuur, terwijl we een duurzaam raamwerk hebben opgezet om de cloudkosten onder controle te houden. Nieuwsgierig naar hoe FinOps je kan helpen om werkkosten te optimaliseren en beter te schalen? Lees er alles over in deze blog.

Langlopende geschiedenis in CapEx-kostenbetaling

Deze grote organisatie is al een paar jaar klant bij ACA Group. Sinds een tijdje verplaatsen ze steeds meer workload van on premise naar Azure. De financiële afdeling was nog steeds bezig met de budgettering en vertrouwde op Capital Expenditure (CapEx), waarbij de IT-infrastructuurkosten vooraf worden betaald en bekend zijn. Dit in tegenstelling tot Operational Expenditure (OpEx), waarbij de kosten dagelijks fluctueren op basis van het daadwerkelijke gebruik van de digitale middelen die in Azure worden verbruikt.

Onze klant had een substantieel maandelijks budget toegewezen voor Azure, dat consequent werd nageleefd. Daardoor was er geen interne aanleiding om FinOps-praktijken te onderzoeken.

Hoe ACA een aanzienlijke IT-kostenbesparing ontdekte

Terwijl ACA deze klant hielp met de migratie van zijn werklast, zagen we een bekend patroon: FinOps was nooit overwogen. Virtuele machines voor alle omgevingen draaiden 24/7 zonder Reserved Instances en niet-productie Storage Accounts maakten gebruik van dure Geo-replicatie.

Dit zette ons aan tot het maken van een snel overzicht van mogelijke besparingen, die we samen met een volledige FinOps-oefening voorstelden. De onmiddellijke besparingen waren zo overtuigend dat de klant snel akkoord ging met ons voorstel.

Wat is een FinOps-oefening?

Als we het hebben over FinOps, verwijzen we naar de standaarden die zijn opgesteld door de FinOps foundation. Dit is een groot project van de Linux Foundation met een enorme community van meer dan 23.000 leden en 10.000 bedrijven.

In een FinOps-oefening begeleiden we onze klanten door twee deliverables:

- FinOps beoordeling: Dit richt zich op de organisatorische afstemming van onze klant, waarbij we benadrukken dat FinOps een gedeelde verantwoordelijkheid is. Een technicus die een resource inzet in Azure moet rekening houden met kosten zoals grootte en SKU, terwijl de zakelijke afdeling moet zorgen voor voldoende budget voor projecten en resources. Deze mentaliteit moet zich uitstrekken over de hele organisatie.

- Technische evaluatie: Dit richt zich op de huidige setup en hoe deze kan worden geoptimaliseerd om kosten te besparen. We analyseren de volledige Azure-omgeving om optimalisatiekansen te detecteren.

Kostenbesparing vs. waardemaximalisatie

Het doel van FinOps is niet om de clouduitgaven te minimaliseren, maar om de waarde die onze klanten krijgen door het gebruik van cloudservices te maximaliseren. Dit onderscheid is essentieel, maar wordt vaak verkeerd begrepen. Elke resource in Azure moet worden gebruikt op een manier die de hoogst mogelijke bedrijfswaarde oplevert.

Het maximaliseren van de bedrijfswaarde helpt ook de ecologische voetafdruk van onze klanten te minimaliseren. Het is een resultaat dat nauw aansluit bij ACA's streven naar duurzaamheid.

De webapplicatie van de klant optimaliseren

Laten we eens kijken naar de webapplicatie van onze klant die draait op een Azure App Service. Elke gebruikersinteractie genereert een belasting voor het systeem en waarde voor het bedrijf.

Laten we voor het gemak zeggen dat de bedrijfswaarde 1 EUR is elke keer dat een gebruiker de webapplicatie opent. Met duizenden gebruikers levert de applicatie 1000 euro aan waarde.

Het is onze taak om ervoor te zorgen dat de App Service is geoptimaliseerd om deze vraag effectief af te handelen, zodat de bedrijfswaarde wordt gemaximaliseerd. Als we de App Service moeten opschalen, is dat een goede zaak! Zolang we de meest efficiënte middelen en instellingen gebruiken, vergroten we de capaciteit en helpen we de klant om nog meer waarde te genereren.

Selecteren van de belangrijkste aandachtspunten met alle belanghebbenden

Het FinOps Assessment omvat meerdere workshops met de belangrijkste stakeholders van onze klant. We brachten de Finance, Business, Engineering en Operations van de klant samen om te laten zien hoe zij allemaal een rol spelen in de cloudkosten.

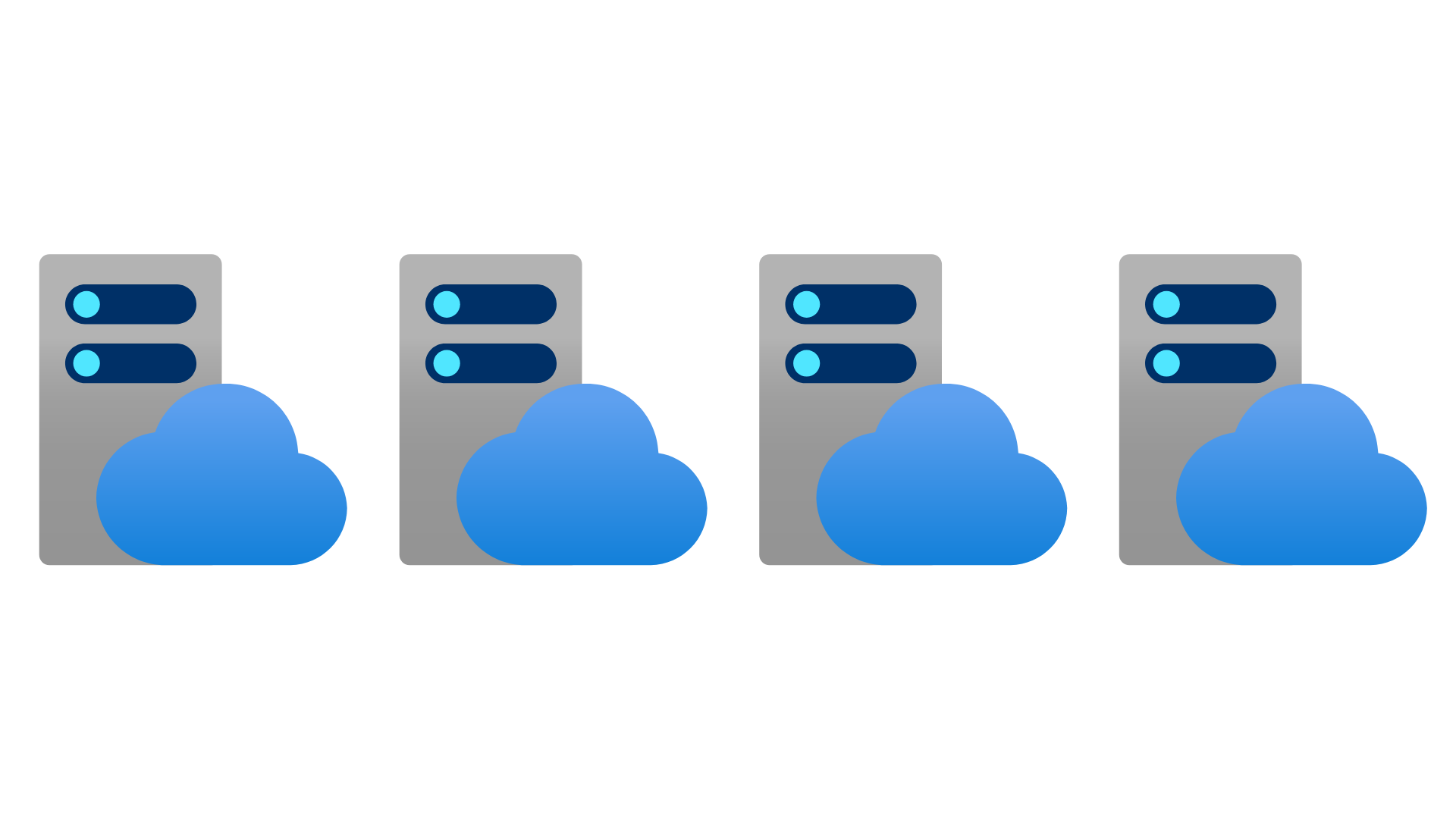

Met meer dan 20 Target Capability Scopes in FinOps selecteert de klant een paar belangrijke gebieden om zich op te richten voor optimalisatie. In dit geval selecteerde de klant het volgende:

Anomaliebeheer

Anomaliebeheer richt zich op onverwachte of abnormale uitgavenpatronen in de cloud. In 2024 ervoer de klant bijvoorbeeld een stijging in de kosten voor een schaalset voor virtuele machines gedurende een paar weken. Ze realiseerden zich dat detectie te lang duurde en wilden betere controles om dit te voorkomen.

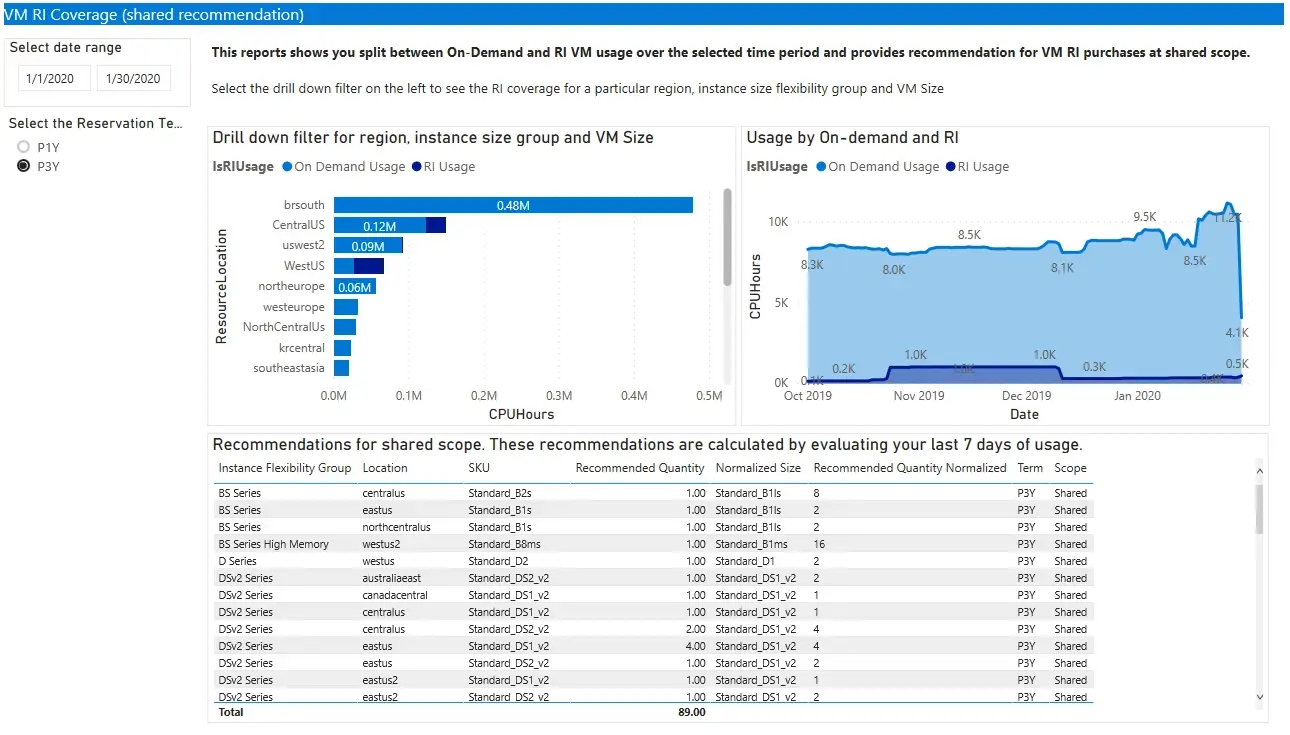

Tariefoptimalisatie

Tariefoptimalisatie zorgt ervoor dat de meest kosteneffectieve prijsmodellen en kortingen worden gebruikt. Voordat we met de FinOps-oefening begonnen, hadden we al potentiële besparingen geïdentificeerd, bijvoorbeeld door Reserved Instances te gebruiken. Daarnaast analyseerden we het tarief dat ze betaalden voor Azure resources.

Werklast optimalisatie

Werklast optimalisatie

Workload Optimization zorgt ervoor dat resources zoals App Services en Virtual Machines efficiënt worden gebruikt. Is het bijvoorbeeld zinvol voor een niet-productieomgeving om de resources 24/7 te laten draaien?

Doelmogelijkheden beoordelen via workshops

Samen met de klant stellen we doelen voor elke Target Capability. Ze zeiden bijvoorbeeld dat Anomaly Management erg belangrijk voor ze is en dat ze op dat gebied een Knowledge Leader willen worden.

Tijdens de workshops met alle belanghebbenden was het onze rol om de juiste vragen te stellen om de geselecteerde Target Capability Scopes te beoordelen. Voor Anomaly Management werd het duidelijk dat ze nog in de beginfase zaten, waardoor ze een "1/Deeltelijke Kennis" evaluatie kregen in dat onderdeel.

Toen alle workshops waren afgerond, konden we een eindoordeel vellen over alle Target Capability Scores. Dit gaf de klant een benchmark, wat betekent dat we bij de volgende evaluatie over 4 maanden kunnen zien hoe ver ze zijn gekomen met betrekking tot hun doelen.

In technische details duiken

Nu de workshops achter de rug waren, konden we ons richten op het geschreven rapport en verder duiken in de technische details van de Azure-omgeving van de klant.

Dit bestond uit twee delen:

Deel 1: Gegevens verzamelen

We draaiden scripts voor het verzamelen van informatie om configuratiedetails te extraheren en in een leesbaarder formaat te presenteren.

Deel 2: Handmatige beoordeling

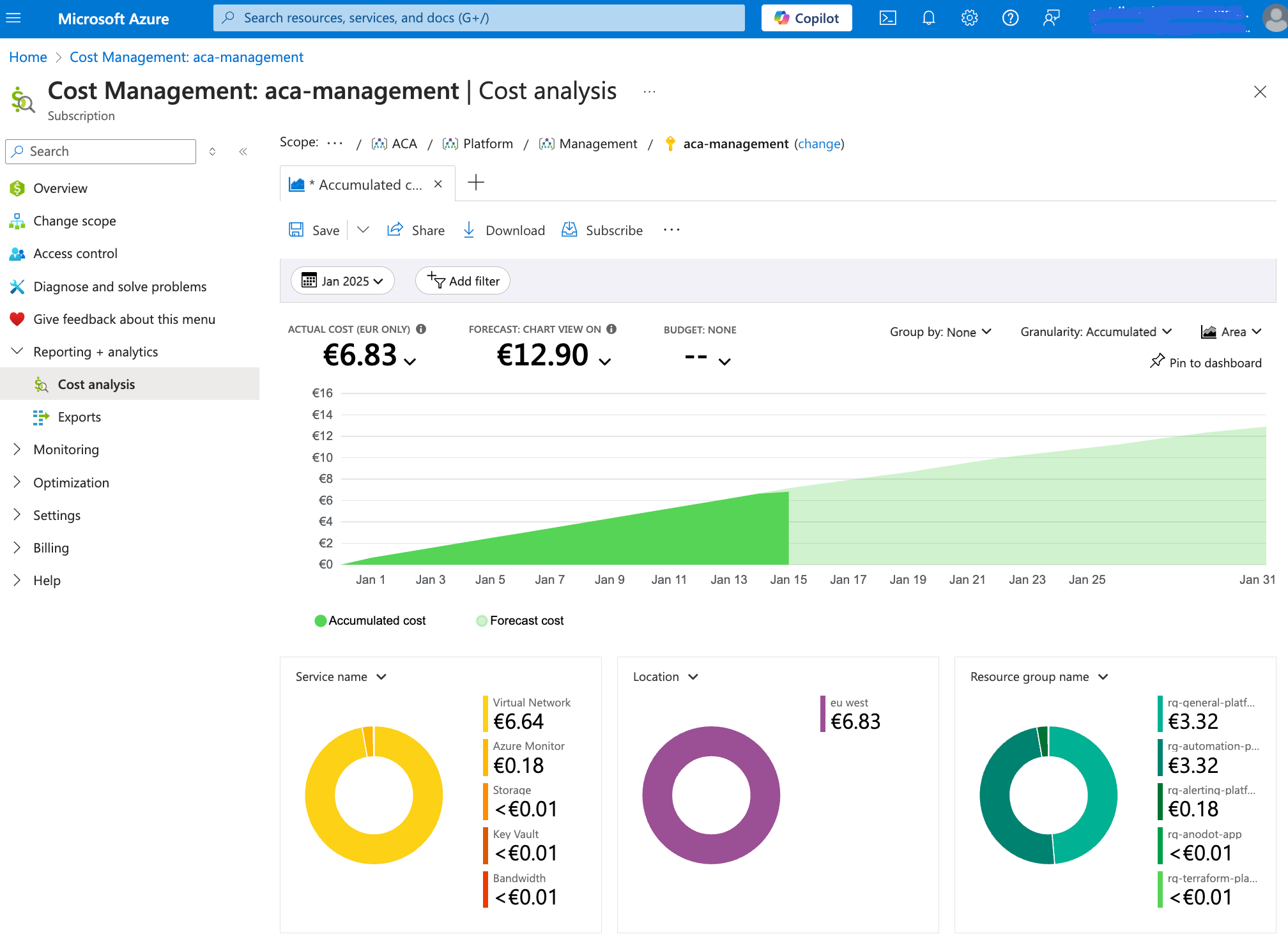

We analyseerden handmatig de resultaten van tools zoals Azure Cost Management en Advisor.

De belangrijkste gebieden voor kostenbesparingen

Met zowel de uitvoer van de scripts als de gegevens van de portal, zagen we dat de volgende gebieden de grootste besparingen konden opleveren:

- Een besparingsplan implementeren / gereserveerde instanties

- Herconfigureer redundantie voor alle Storage Accounts, ze waren allemaal ingesteld op: Geo Redundante Opslag (GRS)

- Niet-productie naar lokale redundante opslag (LRS)

- Productie naar Zone Redundante Opslag (ZRS)

- Afsluiten en verwijderen van computermiddelen plannen voor niet-productie

- Implementeer Governance framework(Azure Policies) om inzet van overmatige SKU's te voorkomen. Bijvoorbeeld, dure Azure Virtual Machines met nVidia-videokaarten moeten worden verboden.

- Implementeer budgetdrempels en waarschuwingen bij afwijkingen

- Implementeer de FinOps Toolkit samen met de PowerBI-rapportage

- Gebruik maken van Anodot voor één enkel venster op hun meerdere omgevingen

We hebben onze bevindingen en aanbevelingen gebundeld in een schriftelijk rapport. Samen met de klant beoordeelden we het rapport en stippelden we vervolgstappen uit.

💡 Een van de aanbevelingen was om de FinOps Toolkit te implementeren. Dit is een set besturingselementen, Power BI-rapporten en werkboeken die zijn afgestemd op het FinOps-raamwerk. We waren blij om te zien dat ze dit samen met onze andere aanbevelingen hebben omarmd.

Vooruitkijken met hernieuwde focus op bedrijfswaarde

In de toekomst zal de klant Azure blijven gebruiken voor zijn workload. Het verschil vanaf nu is dat ze het zullen doen met de mindset van het maximaliseren van de bedrijfswaarde. Over vier maanden zal ACA de status van de FinOps-reis opnieuw beoordelen en hen helpen meten hoe ver ze zijn gekomen.

De langetermijnstrategie houdt ook in dat ACA gebruikmaakt van de strategische samenwerking met Anodot voor FinOps. Samen verleggen we de grenzen van FinOps door kostenefficiëntie te combineren met carbon accountability. Dit zorgt voor een standaard toolset en een uniforme zichtbaarheid van FinOps in al hun omgevingen.

➡️ Bij ACA Group zijn we experts in FinOps! Laat ons u begeleiden tijdens het FinOps-traject om ervoor te zorgen dat u het volledige potentieel van uw cloudinvestering benut.

What others have also read

In de complexe wereld van moderne softwareontwikkeling worden bedrijven geconfronteerd met de uitdaging om verschillende applicaties die door verschillende teams worden ontwikkeld en beheerd, naadloos te integreren. De Service Mesh is van onschatbare waarde bij het overwinnen van deze uitdaging. In dit blogartikel verdiepen we ons in Istio Service Mesh en onderzoeken we waarom investeren in een Service Mesh zoals Istio een slimme zet is." Wat is Service Mesh? Een Service Mesh is een softwarelaag die verantwoordelijk is voor alle communicatie tussen applicaties, in deze context services genoemd. Het introduceert nieuwe functionaliteiten om de interactie tussen services te beheren, zoals monitoring, logging, tracing en verkeerscontrole. Een service mesh werkt onafhankelijk van de code van elke individuele service, waardoor het over netwerkgrenzen heen kan werken en kan samenwerken met verschillende beheersystemen. Dankzij een service mesh kunnen ontwikkelaars zich richten op het bouwen van toepassingsfuncties zonder zich zorgen te maken over de complexiteit van de onderliggende communicatie-infrastructuur. Istio Service Mesh in de praktijk Denk aan het beheren van een groot cluster waarop meerdere applicaties draaien die ontwikkeld en onderhouden worden door verschillende teams, elk met verschillende afhankelijkheden zoals ElasticSearch of Kafka. Na verloop van tijd resulteert dit in een complex ecosysteem van applicaties en containers, overzien door verschillende teams. De omgeving wordt zo ingewikkeld dat het voor beheerders steeds moeilijker wordt om het overzicht te bewaren. Dit leidt tot een reeks pertinente vragen: Hoe ziet de architectuur eruit? Welke applicaties interageren met elkaar? Hoe wordt het verkeer beheerd? Bovendien zijn er specifieke uitdagingen die voor elke afzonderlijke applicatie moeten worden aangepakt: Het afhandelen van aanmeldingsprocessen Implementeren van robuuste beveiligingsmaatregelen Netwerkverkeer beheren dat naar de applicatie wordt geleid ... Een Service Mesh, zoals Istio, biedt een oplossing voor deze uitdagingen. Istio fungeert als een proxy tussen de verschillende applicaties (services) in het cluster, waarbij elk verzoek door een component van Istio gaat. Hoe werkt Istio Service Mesh? Istio introduceert een sidecar proxy voor elke service in het microservices ecosysteem. Deze sidecar proxy beheert al het inkomende en uitgaande verkeer voor de dienst. Daarnaast voegt Istio componenten toe die het inkomende en uitgaande verkeer van het cluster afhandelen. Istio's control plane maakt het mogelijk om beleidsregels te definiëren voor verkeersbeheer, beveiliging en monitoring, die vervolgens worden toegepast op de toegevoegde componenten. Voor een beter begrip van de functionaliteit van Istio Service Mesh, zie ons blogartikel "Istio Service Mesh installeren: A Comprehensive Step-by-Step Guide" , een gedetailleerde, stapsgewijze uitleg over de installatie en het gebruik van Istio. Waarom Istio Service Mesh? Verkeersbeheer: Istio maakt gedetailleerd verkeersbeheer mogelijk, waardoor ontwikkelaars eenvoudig verkeer tussen verschillende versies van hun services kunnen routeren, verdelen en controleren. Beveiliging: Istio biedt een robuuste beveiligingslaag met functies zoals verkeersversleuteling met behulp van eigen certificaten, Role-Based Access Control (RBAC) en mogelijkheden voor het implementeren van authenticatie- en autorisatiebeleid. Waarneembaarheid: Door middel van ingebouwde instrumentatie biedt Istio diepgaande observeerbaarheid met tools voor monitoring, logging en gedistribueerde tracering. Hierdoor kunnen IT-teams de prestaties van services analyseren en snel problemen opsporen. Vereenvoudigde communicatie: Istio neemt de complexiteit van servicecommunicatie weg van applicatieontwikkelaars, zodat zij zich kunnen richten op het bouwen van applicatiefuncties. Is Istio geschikt voor uw opstelling? Hoewel de voordelen duidelijk zijn, is het essentieel om te overwegen of de extra complexiteit van Istio past bij jouw specifieke opstelling. Ten eerste is er een sidecar container nodig voor elke ingezette service, wat kan leiden tot ongewenste geheugen- en CPU overhead. Daarnaast kan het zijn dat je team niet beschikt over de specialistische kennis die nodig is voor Istio. Als je overweegt om Istio Service Mesh te gaan gebruiken, vraag dan begeleiding aan specialisten met expertise. Vraag onze experts gerust om hulp. Meer informatie over Istio Istio Service Mesh is een technologische game-changer voor IT-professionals die streven naar geavanceerde controle, beveiliging en observeerbaarheid in hun microservices-architectuur. Istio vereenvoudigt en beveiligt de communicatie tussen services, waardoor IT-teams zich kunnen richten op het bouwen van betrouwbare en schaalbare applicaties. Snel antwoord nodig op al uw vragen over Istio Service Mesh? Neem contact op met onze experts

Lees verder

Bent u dit jaar niet op KubeCon geweest? Lees dan mee voor onze hoogtepunten van de KubeCon / CloudNativeCon-conferentie van dit jaar door het Cloud Native-team van ACA Group! Wat is KubeCon / CloudNativeCon? KubeCon (Kubernetes Conference) / CloudNativeCon , jaarlijks georganiseerd op EMAE door de Cloud Native Computing Foundation (CNCF), is een vlaggenschipconferentie die adopters en technologen van toonaangevende open source en cloud native gemeenschappen op één locatie samenbrengt. Dit jaar kwamen ongeveer 5.000 fysieke en 10.000 virtuele deelnemers opdagen voor de conferentie. CNCF is de open source, leverancier-neutrale hub van cloud native computing, die projecten zoals Kubernetes en Prometheus host om cloud native universeel en duurzaam te maken. Er waren meer dan 300 sessies van partners, industrieleiders, gebruikers en leveranciers over onderwerpen als CI/CD, GitOps, Kubernetes, machine learning, observeerbaarheid, netwerken, prestaties, service mesh en beveiliging. Het is duidelijk dat er altijd iets interessants te horen is op KubeCon, ongeacht je interessegebied of expertiseniveau! Het is duidelijk dat het Cloud Native ecosysteem is uitgegroeid tot een volwassen, trendsettende en revolutionaire game-changer in de industrie. Alles staat in het teken van de Kubernetes-trend en een enorme hoeveelheid organisaties die cloud native producten ondersteunen, gebruiken en hun bedrijf hebben laten groeien door ze te bouwen of te gebruiken in bedrijfskritische oplossingen. De belangrijkste thema's van 2022 Wat ons opviel tijdens KubeCon dit jaar waren de volgende hoofdthema's: De eerste was toenemende volwassenheid en stabilisatie van Kubernetes en bijbehorende producten voor monitoring, CI/CD, GitOps, operators, costing en service meshes, plus bug fixing en kleine verbeteringen. De tweede is een meer uitgebreide focus op beveiliging . Het veiliger maken van pods, het voorkomen van pod trampoline breakouts, end-to-end encryptie en het maken van volledige analyses van bedreigingen voor een complete k8s bedrijfsinfrastructuur. De derde is duurzaamheid en een groeiend bewustzijn dat systemen waarop k8s en de apps erop draaien veel energie verbruiken terwijl 60 tot 80% van de CPU ongebruikt blijft. Zelfs talen kunnen energie(on)efficiënt zijn. Java is een van de meest energie-efficiënte talen, terwijl Python dat blijkbaar veel minder is door de aard van de interpreter/compiler. Bedrijven moeten allemaal plannen maken en werken aan het verminderen van de energievoetafdruk in zowel applicaties als infrastructuur. Autoscaling zal hierbij een belangrijke rol spelen. Hoogtepunten van de sessies Duurzaamheid Datacenters verbruiken wereldwijd 8% van alle opgewekte elektriciteit. We moeten dus nadenken over het effectieve gebruik van onze infrastructuur en inactieve tijd vermijden (gemiddeld is het CPU-gebruik slechts tussen 20 en 40%) als servers draaien, laat ze dan werken met zoveel mogelijk werklasten resources afsluiten wanneer ze niet nodig zijn door het toepassen van autoscaling benaderingen de coderingstechnologie die gebruikt wordt in je software, sommige programmeertalen gebruiken minder CPU. CICD / GitOps GitOps automatiseert infrastructuur updates met behulp van een Git workflow met continue integratie (CI) en continue levering (CI/CD). Wanneer nieuwe code wordt samengevoegd, voert de CI/CD pijplijn de verandering door in de omgeving. Flux is hier een goed voorbeeld van. Flux biedt GitOps voor zowel apps als infrastructuur. Het ondersteunt GitRepository, HelmRepository en Bucket CRD als de enige bron van waarheid. Met A/B- of Canary-implementaties is het eenvoudig om nieuwe functies te implementeren zonder dat dit gevolgen heeft voor alle gebruikers. Als de implementatie mislukt, kan deze eenvoudig worden teruggedraaid. Bekijk het schema van KubeCon voor meer informatie! Kubernetes Hoewel Kubernetes 1.24 een paar weken voor de start van het evenement werd uitgebracht, waren er niet veel gesprekken gericht op de kern van Kubernetes. De meeste gesprekken waren gericht op het uitbreiden van Kubernetes (met behulp van API's, controllers, operators, ...) of best practices rond beveiliging, CI/CD, monitoring ... voor wat er ook draait binnen het Kubernetes-cluster. Als je geïnteresseerd bent in de nieuwe functies die Kubernetes 1.24 te bieden heeft, kun je de officiële website bekijken . Waarneembaarheid Inzicht krijgen in hoe je applicatie draait in je cluster is cruciaal, maar niet altijd even praktisch. Dit is waar eBPF om de hoek komt kijken, dat wordt gebruikt door tools zoals Pixie om gegevens te verzamelen zonder codewijzigingen. Bekijk het schema van KubeCon voor meer informatie! FinOps Nu steeds meer mensen Kubernetes gebruiken, zijn er veel workloads gemigreerd. Al deze containers hebben een voetafdruk. Geheugen, CPU, opslag, ... moeten worden toegewezen, en ze hebben allemaal een kostprijs. Kostenbeheer was een terugkerend onderwerp tijdens de gesprekken. Het gebruik van autoscaling (capaciteit toevoegen maar ook verwijderen) om de benodigde resources aan te passen en het identificeren van ongebruikte resources maken deel uit van deze nieuwe beweging. Nieuwe diensten zoals 'kubecost' worden steeds populairder. Prestaties Een van de meest voorkomende problemen in een cluster is niet genoeg ruimte of resources hebben. Met behulp van een Vertical Pod Autoscaler (VPA) kan dit tot het verleden behoren. Een VPA analyseert en slaat geheugen- en CPU-metriek/gegevens op om zich automatisch aan te passen aan de juiste CPU- en geheugenlimieten. De voordelen van deze aanpak laten je geld besparen, verspilling voorkomen, de onderliggende hardware optimaal dimensioneren, resources op worker nodes afstemmen en de plaatsing van pods in een Kubernetes cluster optimaliseren. Bekijk het schema van KubeCon voor meer informatie! Servicemesh We weten allemaal dat het heel belangrijk is om te weten welke applicatie data deelt met andere applicaties in je cluster. Service mesh biedt verkeerscontrole binnen uw cluster(s). Je kunt elk verzoek dat wordt verzonden of ontvangen van een applicatie naar andere applicaties blokkeren of toestaan. Het biedt ook Metrics, Specs, Split, ... informatie om de gegevensstroom te begrijpen. In de lezing Service Mesh op schaal: Hoe Xbox Cloud Gaming 22k Pods beveiligt met Linkerd , legt Chris uit waarom ze voor Linkerd hebben gekozen en wat de voordelen zijn van een service mesh. Bekijk het schema van KubeCon voor meer informatie! Beveiliging Trampoline pods, klinkt leuk, toch? Tijdens een lezing van twee beveiligingsonderzoekers van Palo Alto Networks leerden we dat ze niet zo leuk zijn. Kort gezegd zijn dit pods die gebruikt kunnen worden om cluster admin privileges te krijgen. Om meer te leren over het concept en hoe ermee om te gaan, raden we je aan om de slides op de KubeCon schedule pagina te bekijken! Lachlan Evenson van Microsoft gaf een duidelijke uitleg over Pod Security in zijn The Hitchhiker's Guide to Pod Security talk. Pod Security is een ingebouwde toelatingscontroleur die Pod-specificaties evalueert aan de hand van een vooraf gedefinieerde set Pod Security-standaarden en bepaalt of de pod moet worden toegelaten of geweigerd. - Lachlan Evenson , Programmamanager bij Microsoft . Pod Security vervangt PodSecurityPolicy vanaf Kubernetes 1.23. Dus als je PodSecurityPolicy gebruikt, is dit misschien een goed moment om Pod Security en het migratiepad verder te onderzoeken. In versie 1.25 wordt de ondersteuning voor PodSecurityPolicy verwijderd. Als je PodSecurityPolicy of Pod Security niet gebruikt, is het zeker tijd om het verder te onderzoeken! Een ander terugkerend thema van deze KubeCon 2022 waren operators. Operators maken het mogelijk om de Kubernetes API uit te breiden met operationele kennis. Dit wordt bereikt door Kubernetes-controllers te combineren met bekeken objecten die de gewenste toestand beschrijven. Ze introduceren Custom Resource Definitions, custom controllers, Kubernetes of cloud resources en logging en metrics, wat het leven makkelijker maakt voor zowel Dev als Ops. Tijdens een lezing van Kevin Ward van ControlPlane leerden we echter dat er ook risico's aan verbonden zijn. Bovendien, en dat is nog belangrijker, vertelde hij ook hoe we die risico's kunnen identificeren met tools zoals BadRobot en een operator thread matrix . Bekijk de KubeCon roosterpagina voor meer informatie! Planning Telemetry Aware Scheduling helpt u om uw workloads te plannen op basis van de statistieken van uw worker nodes. U kunt bijvoorbeeld een regel instellen om geen nieuwe werklasten te plannen op worker nodes met meer dan 90% gebruikt geheugen. Het cluster zal hier rekening mee houden bij het plannen van een pod. Een andere leuke functie van deze tool is dat het ook pods opnieuw kan inplannen om ervoor te zorgen dat uw regels in lijn blijven. Bekijk de KubeCon planningspagina voor meer informatie! Cluster autoscaling Een geweldige manier voor stateless workloads om kosteneffectief te schalen is het gebruik van AWS EC2 Spot, wat reserve VM-capaciteit is die met korting beschikbaar is. Om Spot-instanties effectief te gebruiken in een K8S cluster, moet je aws-node-termination-handler gebruiken. Op deze manier kun je je werklasten van een worker node verplaatsen wanneer Spot besluit deze terug te vorderen. Een ander goed hulpmiddel is Karpenter , een hulpmiddel om Spot-instanties precies op tijd te leveren voor je cluster. Met deze twee tools kun je je stateless workloads kosteneffectief hosten! Bekijk de KubeCon schedule pagina voor meer informatie! Event-gedreven autoscaling Het gebruik van de Horizontal Pod Autoscaler (HPA) is een geweldige manier om pods te schalen op basis van statistieken zoals CPU-gebruik, geheugengebruik en meer. In plaats van te schalen op basis van statistieken, kan Kubernetes Event Driven Autoscaling (KEDA) schalen op basis van gebeurtenissen (Apache Kafka, RabbitMQ, AWS SQS, ...) en het kan zelfs schalen tot 0 in tegenstelling tot HPA. Bekijk het schema van KubeCon voor meer informatie! Wrap-up We hebben dit jaar genoten van de conferentie. We vertrokken met een geïnspireerd gevoel dat we ongetwijfeld zullen vertalen naar interne projecten, nieuwe klantprojecten zullen aanvragen en waar van toepassing zullen bespreken met bestaande klanten. Niet alleen dat, maar we zullen ook onze collega's informeren en een afterglow sessie organiseren voor de geïnteresseerden thuis in België. Als je ons blogartikel leuk vond, stuur ons dan gerust een berichtje. We zijn altijd blij als de inhoud die we publiceren ook voor jou waardevol of interessant is. Als je denkt dat we jou of je bedrijf kunnen helpen bij de adoptie van Cloud Native, stuur me dan een berichtje op peter.jans@aca-it.be. Als laatste willen we Mona bedanken voor de logistiek, Stijn en Ronny voor deze kans en de rest van het team dat achterbleef om de systemen van onze gewaardeerde klanten in de gaten te houden.

Lees verder

Op 7 en 8 december 2023 namen verschillende ACA-leden deel aan CloudBrew 2023 , een inspirerende tweedaagse conferentie over Microsoft Azure. In het decor van de voormalige Lamot brouwerij kregen bezoekers de kans om zich te verdiepen in de nieuwste cloudontwikkelingen en hun netwerk uit te breiden. Met verschillende tracks en boeiende sprekers bood CloudBrew een schat aan informatie. De intieme setting stelde deelnemers in staat om direct contact te leggen met zowel lokale als internationale experts. In dit artikel lichten we graag enkele van de meest inspirerende lezingen van deze tweedaagse cloudbijeenkomst uit: Azure-architectuur: Verstandig kiezen Rik Hepworth , Chief Consulting Officer bij Black Marble en Microsoft Azure MVP/RD, gebruikte een klantvoorbeeld waarbij .NET ontwikkelaars verantwoordelijk waren voor het beheer van de Azure infrastructuur. Hij betrok het publiek in een interactieve discussie om de beste technologieën te kiezen. Hij benadrukte verder het belang van een gebalanceerde aanpak, waarbij nieuwe kennis wordt gecombineerd met bestaande oplossingen voor effectief beheer en ontwikkeling van de architectuur. Van gesloten platform naar landingszone met Azure Policy David de Hoop , Special Agent bij Team Rockstars IT, vertelde over de Azure Enterprise Scale Architecture, een template van Microsoft die bedrijven ondersteunt bij het opzetten van een schaalbare, veilige en beheersbare cloud-infrastructuur. De template biedt richtlijnen voor het ontwerpen van een cloudinfrastructuur die kan worden aangepast aan de behoeften van een bedrijf. Een cruciaal aspect van deze architectuur is de landingszone, een omgeving die zich houdt aan ontwerpprincipes en alle applicatieportfolio's ondersteunt. Het maakt gebruik van abonnementen om applicatie- en platformbronnen te isoleren en te schalen. Azure Policy biedt een reeks richtlijnen om Azure-infrastructuur open te stellen voor een onderneming zonder in te boeten aan beveiliging of beheer. Dit geeft engineers meer vrijheid in hun Azure-omgeving, terwijl beveiligingsfuncties automatisch worden afgedwongen op tenantniveau en zelfs applicatiespecifieke instellingen. Dit zorgt voor een evenwichtige aanpak om zowel flexibiliteit als beveiliging te garanderen, zonder dat er aparte tools of technologieën nodig zijn. De grootste Azure fouten van België waarvan ik wil dat jij ervan leert! Tijdens deze sessie presenteerde Toon Vanhoutte , Azure Solution Architect en Microsoft Azure MVP, de meest voorkomende fouten en menselijke vergissingen, gebaseerd op de ervaringen van meer dan 100 Azure engineers. Aan de hand van waardevolle praktijkvoorbeelden illustreerde hij niet alleen de fouten zelf, maar bood hij ook duidelijke oplossingen en preventieve maatregelen om soortgelijke incidenten in de toekomst te voorkomen. Zijn waardevolle inzichten hielpen zowel beginnende als ervaren Azure engineers hun kennis aan te scherpen en hun implementaties te optimaliseren. Kritieke ICS SCADA-infrastructuur beschermen met Microsoft Defender Deze presentatie van Microsoft MVP/RD, Maarten Goet , richtte zich op het gebruik van Microsoft Defender voor ICS SCADA infrastructuur in de energiesector. De spreker deelde inzichten over het belang van cyberbeveiliging in deze kritieke sector en illustreerde dit met een demo waarin de kwetsbaarheden van dergelijke systemen werden gedemonstreerd. Hij benadrukte de noodzaak van proactieve beveiligingsmaatregelen en benadrukte Microsoft Defender als een krachtige tool voor het beschermen van ICS SCADA-systemen. Azure Digital Twin gebruiken in productie Steven De Lausnay , Specialist Lead Data Architecture en IoT Architect, introduceerde Azure Digital Twin als een geavanceerde technologie om digitale replica's te maken van fysieke omgevingen. Door inzicht te geven in het proces achter Azure Digital Twin, liet hij zien hoe organisaties in productieomgevingen gebruik kunnen maken van deze technologie. Hij benadrukte de waarde van Azure Digital Twin voor het modelleren, monitoren en optimaliseren van complexe systemen. Deze technologie kan een cruciale rol spelen bij het verbeteren van de operationele efficiëntie en het nemen van datagestuurde beslissingen in verschillende industriële toepassingen. Azure Platform aanbevelingen omzetten in goud Magnus Mårtensson , CEO van Loftysoft en Microsoft Azure MVP/RD, had de eer om CloudBrew 2023 af te sluiten met een boeiende samenvatting van de hoogtepunten. Met zijn onderhoudende presentatie bood hij waardevolle reflectie op de verschillende thema's die tijdens het evenement waren besproken. Het was een perfecte afsluiting van een zeer succesvolle conferentie en gaf iedere deelnemer zin om de opgedane inzichten direct in de praktijk te brengen. We kijken nu al uit naar CloudBrew 2024! 🚀

Lees verderWant to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!

Want to dive deeper into this topic?

Get in touch with our experts today. They are happy to help!